正常状态下,人在说话时心理情感的波动会引起声压、语气、语速、停顿时间和发声器官的微小变化,以及通过人体大脑皮层的生理反应,利用心理学、生理学、神经科学、信号分析处理、人工智能等的诸多前沿科技,检测分析语音中某些特征参数的变化,因此,检信智能通过监测这些特征变化实现心理情感分析。

根据当前语音情感分析的不足,检信智能通过多年语音情感识别技术的开发经验,结合循环神经网络具有记忆性、参数共享等特征,对序列的非线性特征在学习方面具有一定优势,利用基于LSTM(LongShort-Term Memory)长短期记忆网络,将一种时间循环神经网络,应用于处理和预测时间序列中间隔和延迟相对较长的重要事件,解决长序列训练过程中的梯度消失和梯度爆炸问题。相比普通的RNN,LSTM能够在更长的序列中有更好的表现,通过将卷积操作引入长短时记忆网络中,构建完整的语音心理情感网络模型,将语音进行统一归一化处理,再对统一归一化处理的语音进行分割之后,对割分的语音加窗分帧处理,并建立变长数据的计算方式,将卷积操作引入长短时记忆网络中,实现完整的语音情感识别网络模型,并识别平静、高兴、吃惊、悲伤、愤怒、厌恶和恐惧7种情感功能。

目前市场上语音心理情感分析存在如下:

(1)心理情感与语音特征的逻辑关系不够明确;

(2)从语音数据采集到语音特征的提取降噪处理不够导致信息的损失,而损失的信息影响最终心理情感检测的 效果;

(3)分类算法效果一定程度上依赖人为提取的语音特征,算法本身不具有特征学习能力。

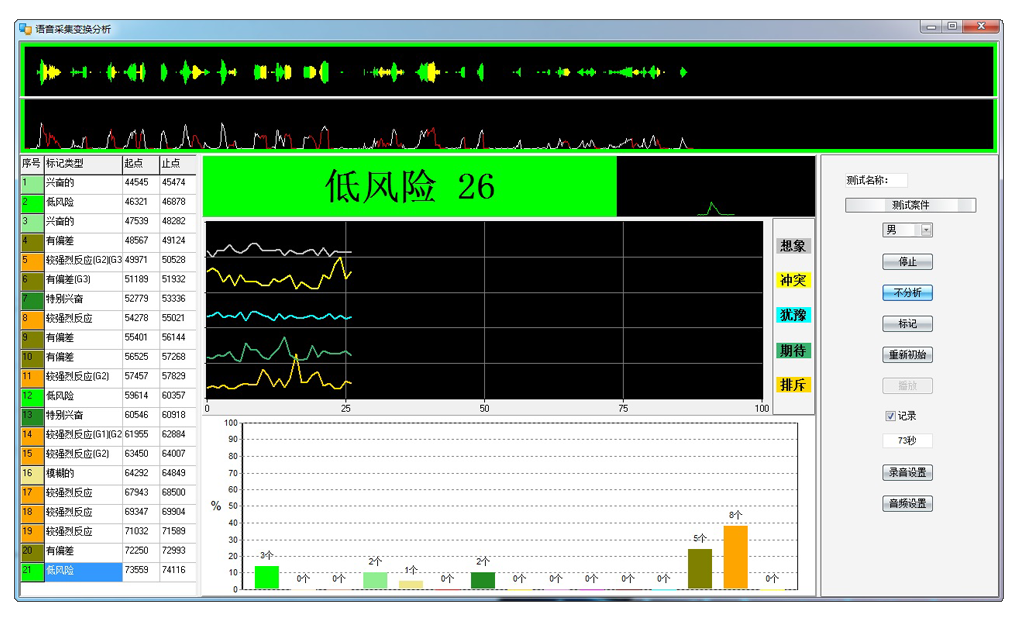

根据语音情感数据,检信Allemotion平台根据特有的情绪建模及神经网络获得被测试者每一时刻或在说话片段中的害怕、排斥、冲突、期待、压力、兴奋、逻辑、比率、概率、分心、犹豫、认知、紧张、坏感、想象、思考、潜意识、潜在情绪。

(1)系统的识别时延低于250ms。

因为在线语音情感识别,如果时延过高不但影响用户体验,而且对后续的语音情感识别请求的处理时间就更加长,发生堵塞。时延低是系统最重要的要求,要求系统对每个语音情感识别的请求处理时间低于250ms。

(2)能够处理大规模并发任务请求。检信ALLEMOTION语音情感识别具有并发任务处理能力。如果对语音情感识别任务的处理是串行的,则依然满足不了大规模的应用。

(3)利用采集针对性的语料进行模型训练,并在引擎模块中语音情感特征提取前加入语音降噪处理步骤,提高了情感识别率。原始语音信号从频谱图上可以看到语音数据中含有一些不规则信号的噪声。下图是经过降噪之后的语音信号变得有规律,可以发现降噪效果还是明显的。经过降噪之后重新训练,明显提高模型的效果,说明经过降噪的语音有效降低环境噪声和设备底噪对语音情感识别的影响。

(4) 采用群体决策优化神经网络方法。

检信ALLEMOTION采用群体决策的方法将训练集按照不同的组合条件,并选出每次交叉验证在测试集上识别效果最好的模型组成一个神经网络群,当进行识别时,神经网络群中的每个模型分别对当前样本进行判断给出情感标签,最后使用投票的方式给出最终识别结果。

(5)语音情感识别精度达到达到82%

(6)检信ALLEMOTION语音情感识别工作稳定性达到99.5% ,运行可靠且有能力处理大规模并发任务。